Estado de Cloud Native 2025: lo que revelan los reportes más influyentes de la industria

Desde Cuemby, como parte activa de la comunidad cloud native y del ecosistema CNCF, entendemos estos reportes como herramientas de trabajo para la industria. Nos permiten pausar la urgencia del día a día, mirar el mapa completo y ubicar nuestra propia realidad dentro de él. Este artículo propone una lectura profunda de esa evidencia: organizamos los datos, destacamos las tendencias que realmente están moviendo el tablero y formulamos preguntas que pueden enriquecer la conversación técnica dentro de tu organización. La invitación es a leerlo con calma, subrayar lo que conecte con tu contexto y usar estos hallazgos como materia prima para tomar decisiones más informadas, especialmente en entornos de mercados emergentes donde cada decisión tecnológica tiene un peso operativo y financiero muy concreto.

Cada año, la “ciencia” de la industria cloud nativa nos deja una radiografía bastante precisa de hacia dónde se está moviendo el mundo: qué tecnologías se consolidan, qué prácticas se quedan en piloto eterno y dónde se están jugando de verdad la eficiencia y la competitividad.

En 2025 esa radiografía viene, sobre todo, de tres fuentes:

- State of Cloud Native Development Q3 2025 (CNCF + SlashData)

- Un conjunto de estudios complementarios:

La tentación es leerlos como algo “interesante, pero lejano”, propio de grandes players globales. El propósito de este artículo es exactamente el contrario: extraer de esos datos ideas que sirvan a cualquier organización, especialmente en mercados emergentes como América Latina, para entender:

- qué está pasando realmente en cloud native,

- qué viene en la intersección con IA, datos y costos,

- y qué preguntas vale la pena hacerse hoy desde nuestra región.

Sin pitch de producto, sin discurso de ventas: solo interpretación técnica, aterrizada.

1. El mapa 2025 del desarrollo cloud native

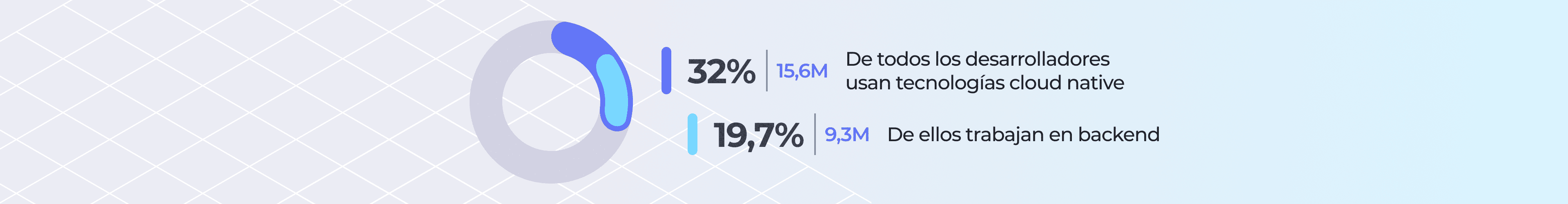

El primer dato clave del informe de CNCF es de escala: 15,6 millones de desarrolladores usan tecnologías cloud native en el mundo, aproximadamente un 32% de todos los desarrolladores. De ellos, unos 9,3 millones trabajan en backend.

(Reporte State of Cloud Native Development Q3 2025)

Entre quienes hacen backend, el cambio es nítido:

- 56% de desarrolladores backend son ya “cloud native” en Q3 2025, frente a 49% apenas seis meses antes.

- 77% de desarrolladores backend usa al menos una tecnología cloud native (contenedores, Kubernetes, observabilidad, serverless, etc.).

(Mismo reporte State of Cloud Native Development Q3 2025)

En otras palabras, el “cloud native” dejó de ser un submundo de SREs y K8s operators y se ha convertido en el contexto normal de trabajo para una mayoría de desarrolladores de backend.

Además, el informe detalla qué usan realmente quienes hacen backend:

- 50% usa gateways de API.

- 46% trabaja con microservicios.

- 30% usa Kubernetes directamente (venía de un pico del 36% en 2023).

- Prácticas más avanzadas como immutable infrastructure o chaos engineering apenas aparecen en 7% y 6% de los desarrolladores backend, respectivamente.

(State of Cloud Native Development Q3 2025)

Ahí ya se dibuja una primera idea para el lector latinoamericano:

Gran parte del mundo está usando resultado de prácticas avanzadas (microservicios, gateways, observabilidad),

mientras que muy pocos equipos han interiorizado todavía prácticas de resiliencia profunda y automatización agresiva.

Es decir, la carrera no terminó. Está cambiando de fase.

2. De “ir a la nube” a decidir cómo estar en la nube

Los reportes coinciden en algo que muchos equipos ya intuyen desde la trinchera: el debate dejó de ser “nube sí o no” y pasó a ser “¿qué mezcla de nubes, on-prem y edge tiene sentido para mis aplicaciones y mis regulaciones?”.

En los datos de CNCF/SlashData:

- Entre todos los desarrolladores, el uso de cloud híbrida sube del 22% en 2021 a alrededor del 30–32% en 2025.

- El multi-cloud alcanza 23–26% según se mire la muestra (backend frente a comunidad total).

- La nube distribuida empieza a aparecer con fuerza en backend: 15% de desarrolladores backend declara usarla en Q3 2025, frente al 12% de principios de año.

(State of Cloud Native Development Q3 2025)

El comunicado y materiales de análisis en torno al reporte resumen bien la tendencia: la nube híbrida y el multi-cloud ganan peso como estrategia estructural; el cloud distribuido emerge en equipos que necesitan correr cargas cerca del usuario y de la fuente de datos.

(Basado en State of Cloud Native Development Q3 2025

¿Por qué importa esto en mercados emergentes?

- Porque regulación de datos, latencia y costos de conectividad suelen ser más retadores en América Latina que en Norteamérica o Europa.

- Y porque replicar sin matices arquitecturas pensadas para empresas con data centers propios en tres continentes puede salir muy caro, sin generar el mismo retorno.

La lectura aquí no es “todos deben ir a híbrido o multi-cloud”, sino otra:

El estándar global se mueve a arquitecturas más distribuidas;

cada región tendrá que diseñar su versión pragmática de ese estándar.

3. IA y cloud native: de la curiosidad a la dependencia mutua

El informe de CNCF introduce una cifra que suele sorprender: solo el 41% de los desarrolladores de IA/ML profesionales se clasifica como “cloud native”.

(State of Cloud Native Development Q3 2025)

La explicación que proponen los autores es interesante: una gran parte de estos equipos usa servicios administrados de ML (MLaaS), que ocultan la infraestructura y reducen el incentivo a aprender patrones cloud native en profundidad. Al mismo tiempo, estiman alrededor de 7,1 millones de desarrolladores que hacen IA/ML y son cloud native (muchos de ellos compartidos con el universo backend).

(Misma fuente: State of Cloud Native Development Q3 2025)

Mientras tanto, el CNCF Tech Radar Q3 2025 muestra el otro lado de la moneda:

- Herramientas de inferencia como NVIDIA Triton, DeepSpeed, TensorFlow Serving y BentoML aparecen en la categoría “adopt” del radar, con altas puntuaciones en utilidad y madurez.

- En orquestación de ML, tecnologías como Apache Airflow se sitúan como recomendadas para adopción.

- En plataformas “agentic” (agentes de IA), conceptos como Model Context Protocol (MCP) y stacks de modelos abiertos aparecen en la zona de adopción.

(CNCF Tech Radar – Q3 2025)

El mensaje implícito es claro:

- La infraestructura cloud native se está convirtiendo en piso mínimo para sacar IA a producción con garantías.

- La IA, a su vez, está empujando la complejidad de esa infraestructura (edge, datos en tiempo real, nuevos patrones de monitoreo y seguridad).

Para un equipo en América Latina, la pregunta práctica no es “¿debo usar Triton o vLLM?”, sino:

- ¿Cómo voy a versionar, desplegar y monitorear modelos de IA con el mismo rigor con el que manejo microservicios?

- ¿Quién de mi equipo entiende Kubernetes, datos y ML al mismo tiempo, y qué brecha de skills tengo que cerrar?

4. Kubernetes en producción: madurez… con dolor de costos

Los datos de State of Production Kubernetes 2025 refuerzan la idea de que Kubernetes ya no es experimental:

- Para las organizaciones encuestadas (todas con más de 250 empleados), Kubernetes es infraestructura misión-crítica.

- 90% espera que sus cargas de IA en K8s crezcan en los próximos 12 meses.

- El multi-entorno es la norma: un “adoptante típico” de Kubernetes opera clusters en cinco o más entornos distintos (tres hyperscalers, on-prem, clouds de GPU o soberanas).

- El costo se convierte en el dolor número uno: 42% lo señalan como principal reto; 88% reportan aumento anual del TCO de Kubernetes; 92% invierten en herramientas de optimización, muchas de ellas impulsadas por IA.

- La edge computing con Kubernetes llega a la corriente principal: 50% dice correr clusters en el edge en producción.

Mientras tanto, el Data on Kubernetes 2025 Report muestra que “DoK” (data on Kubernetes) ya cruzó la frontera de adopción y entró en la fase de excelencia operacional:

- Casi la mitad de las organizaciones ejecuta 50% o más de sus workloads de datos en producción sobre Kubernetes.

- 62% atribuye 11% o más de sus ingresos a despliegues de datos en Kubernetes.

- Las prioridades operativas dejaron de ser “¿se puede?” y se volvieron:

- optimización de rendimiento (46%),

- seguridad y compliance (42%),

- brecha de talento/skills (40%).

- La prioridad número uno para 2025 es optimizar costos, seguida muy de cerca por mejorar capacidades de IA/ML sobre Kubernetes.

- Las cargas que más crecen:

- Bases de datos (66%) se mantienen como workload #1.

- Analítica (57%) y IA/ML (44%) consolidan a Kubernetes como plataforma de datos, no solo de microservicios.

- Vector databases aparecen como infraestructura crítica: alrededor de 80% ya las usa o planea usarlas, y 77% las considera esenciales para RAG y aplicaciones de IA.

Mientras tanto, en la capa de seguridad de versiones, Datadog Security Labs muestra progreso relevante: a octubre de 2025, 78% de los hosts analizados corrían versiones de Kubernetes en soporte “mainstream”, 19% en soporte extendido y solo 3% en versiones no soportadas, ayudados por la aparición de distribuciones con soporte LTS.

(Artículo A 2025 look at real-world Kubernetes version adoption)

Todo este conjunto de datos apunta a una tesis central:

Kubernetes y el ecosistema cloud native ya están en el centro de las cargas de datos e IA,

pero el foco de madurez se movió de “ponerlo en producción” a hacerlo eficiente, seguro y financieramente sostenible.

5. Observabilidad: cuando la caída del sistema tiene precio

Los reportes de New Relic ponen números a algo que muchos equipos sienten pero rara vez cuantifican: cuánto cuesta realmente que “el sistema se caiga”.

(2025 Observability Forecast – New Relic)

En la Observability Forecast 2025 global:

- Un outage de alto impacto tiene un costo mediano de 2 millones de dólares por hora; el costo mediano anual de estos incidentes se sitúa en 76 millones de dólares para las organizaciones encuestadas.

(Datos también citados en el comunicado de prensa de New Relic en BusinessWire: New Relic Study Reveals Businesses Face an Annual Median Cost of $76 Million from High-Impact IT Outages)

- Las organizaciones con observabilidad full-stack logran reducir a la mitad el costo de sus outages de alto impacto (de 2M a ~1M por hora) y reportan menos incidentes y detecciones más rápidas.

En el informe específico para Retail & eCommerce:

- El costo mediano de un outage crítico es de 1 millón de dólares por hora, aproximadamente la mitad del de otros sectores.

- Casi un tercio de los retailers experimenta outages críticos semanalmente.

- 46% declara un ROI de 2x o más en sus inversiones en observabilidad.

- Las empresas están reduciendo el número de herramientas de observabilidad: pasan de un promedio de 5,9 herramientas en 2022 a 3,9 en 2025, y el porcentaje que usa una sola plataforma sube de 3% a 12%.

(Reporte State of Observability for Retail 2025)

La conexión con cloud native es directa:

- A medida que se multiplican los servicios, clusters y regiones, el riesgo de “incendios invisibles” crece.

- Los datos muestran que consolidar observabilidad y llevarla a full-stack no es solo un deseo arquitectónico, sino un mecanismo tangible para reducir pérdidas.

Desde América Latina, donde muchas veces los presupuestos de TI son más ajustados, conviene darle la vuelta a la pregunta:

¿Cuánto de lo que consideramos “caro” en observabilidad o en prácticas de SRE lo es realmente,

y cuánto es simplemente seguro médico para sistemas que ya mueven una parte significativa del negocio?

6. FinOps y el costo de la IA: la nube ya no se gestiona sola

El State of FinOps 2025 ayuda a entender la capa económica de todo lo anterior. En su resumen público y en análisis de terceros:

- La encuesta representa organizaciones que manejan más de 69.000 millones de dólares en gasto cloud.

- 31% de las organizaciones gasta más de 50 millones de dólares anuales solo en servicios cloud.

- 97% invierte en múltiples áreas de infraestructura (pública, privada, SaaS, datos, etc.).

- 63% de las organizaciones ya gestiona gasto en IA como parte de su práctica de FinOps, frente a 31% el año anterior.

- Los equipos de FinOps suelen ocuparse de 12 o más capacidades (optimización, forecasting, reporting, SaaS, licencias, nube privada, data centers, etc.).

En paralelo, el Data on Kubernetes 2025 muestra que la prioridad #1 para quienes corren datos y IA en Kubernetes es optimizar costos, especialmente en almacenamiento y transferencias de datos.

(Data on Kubernetes 2025 Report)

Y el State of Production Kubernetes 2025 cuantifica que 88% de los equipos reportan aumento interanual en el TCO de Kubernetes, mientras que 92% invierte en herramientas de optimización apoyadas en IA.

(State of Production Kubernetes 2025)

Todo esto refuerza una idea que conviene tener presente al leer cualquier reporte de cloud native:

- La discusión ya no es solo arquitectónica (“¿microservicios o monolito?”),

- sino también económica y de gobernanza (“¿quién tiene visibilidad real sobre el gasto de IA, almacenamiento y edge?”).

Para organizaciones en mercados emergentes, donde la elasticidad del presupuesto es menor, estos datos son casi un aviso:

La ola de IA se sube con datos y cloud native,

pero sin disciplina de costos, se convierte rápido en una bola de nieve difícil de frenar.

7. ¿Qué implica todo esto para América Latina?

Los reportes globales no desglosan siempre por región, pero sí nos dan pistas de patrones que resuenan de manera particular en LatAm:

- Brecha de skills en el cruce Kubernetes + datos + IA

- El DoK Report marca la falta de talento con habilidades combinadas en Kubernetes, workloads de datos, performance y gestión de costos como un reto clave para 40% de las organizaciones.

(Data on Kubernetes 2025 Report)

- En América Latina esa brecha suele amplificarse por diferencias salariales, menor disponibilidad de perfiles senior y fuga de talento remoto.

- Sistemas distribuidos en entornos con conectividad desigual

- El aumento global de híbrido, multi-cloud y edge implica diseñar para redes relativamente confiables.

(State of Cloud Native Development Q3 2025, State of Production Kubernetes 2025)

- En muchos países de la región, el diseño tiene que contemplar conectividad intermitente, enlaces caros y data centers locales con capacidades variables.

- Impacto real en negocio, incluso en organizaciones medianas

- Si retailers globales reportan 1M de dólares por hora de outage, y otras industrias 2M/h, no hace falta replicar las cifras para entender la proporción: la caída de un sistema de pagos, logística o salud en LatAm puede ser existencial para un negocio mediano.

(2025 Observability Forecast, State of Observability for Retail 2025)

- Oportunidad de “saltar etapas”

- Muchos de los retos que describen los reportes (tool sprawl, repatriación apresurada, clusters “snowflake” difíciles de operar) nacen de años de decisiones hechas en épocas de crédito barato.

(State of Cloud Native Development Q3 2025, 2025 Observability Forecast, State of FinOps 2025)

- La realidad de restricciones en LatAm abre una posibilidad: diseñar plataformas y prácticas con más frugalidad desde el principio, aprendiendo de errores que otros ya documentaron.

Desde esta perspectiva, la pregunta quizá más productiva para equipos de la región no es “¿estamos atrasados?”, sino:

- ¿Qué partes de estos aprendizajes podemos adoptar de forma selectiva para ganar resiliencia y eficiencia?

- ¿En qué aspectos queremos estar en la “vanguardia”, y en cuáles es mejor ser seguidores inteligentes?

8. Cómo leer estos datos desde tu organización

Usando el State of Cloud Native Development como fuente primaria y los otros reportes como contexto, se puede construir una especie de checklist mental para cualquier equipo técnico o de liderazgo:

- ¿Dónde estamos en la curva de madurez cloud native?

- ¿Usamos contenedores, gateways de API, observabilidad, microservicios de forma consistente?

- ¿Estamos en el grupo del 56% de backend que ya es cloud native… o aún operamos como si la infraestructura fuera estática?

(State of Cloud Native Development Q3 2025)

- ¿Qué tan distribuida es de verdad nuestra infraestructura?

- ¿Tenemos claro cuándo nos conviene on-prem, nube pública, nube soberana o edge?

- ¿Hay una estrategia deliberada para híbrido/multi-cloud o solo acumulación de decisiones?

(State of Cloud Native Development Q3 2025, State of Production Kubernetes 2025)

- IA: ¿caja negra de un proveedor o capacidad propia operable?

- ¿Dependemos exclusivamente de MLaaS, sin visibilidad real de costos ni performance?

(State of Cloud Native Development Q3 2025, CNCF Tech Radar – Q3 2025)

- ¿Quién en la organización entiende al mismo tiempo modelos, datos, Kubernetes, seguridad y costos?

- ¿Cuánto vale una hora de caída en nuestro contexto?

- Aunque las cifras de New Relic sean globales, sirven como espejo: ¿tenemos siquiera una estimación interna?

(2025 Observability Forecast)

- ¿La inversión en observabilidad, SRE y prácticas de resiliencia se está midiendo contra ese costo o contra un “feeling” de caro/barato?

- ¿Quién mira los costos y con qué información?

- ¿Existe algún tipo de práctica de FinOps, aunque sea mínima, que incluya IA, SaaS y data centers?

(State of FinOps 2025)

- ¿Sabemos distinguir entre gasto necesario para capacidad y gasto que viene de ineficiencias (clusters infrautilizados, almacenamiento mal diseñado, transferencia de datos innecesaria)?

Este tipo de preguntas no reemplaza el diseño arquitectónico, pero lo enmarca: ayuda a leer los reportes sin quedarse solo en “subió 10%, bajó 5%”.

9. Hacia dónde se mueve la conversación (y qué viene después)

Si juntamos las piezas, el patrón que aparece para 2025 es bastante consistente:

- Cloud native ya está masivo en backend, y se expande a IA/ML, datos y edge.

(State of Cloud Native Development Q3 2025, Data on Kubernetes 2025 Report, State of Production Kubernetes 2025)

- Las arquitecturas híbridas, multi-cloud y distribuidas se consolidan como realidad de facto.

(State of Cloud Native Development Q3 2025, State of Production Kubernetes 2025)

- Kubernetes deja de ser el fin y se vuelve medio para correr datos, IA y cargas de negocio en producción a escala.

(Data on Kubernetes 2025 Report, State of Production Kubernetes 2025, A 2025 look at real-world Kubernetes version adoption)

- La conversación se desplaza de “adopción” a “operational excellence”: performance, observabilidad, seguridad, costos.

(Data on Kubernetes 2025 Report, 2025 Observability Forecast, State of FinOps 2025)

- Y la práctica de FinOps se expande para abarcar IA, SaaS y otros gastos tecnológicos variables.

(State of FinOps 2025)

Para América Latina, esto abre al menos tres líneas de reflexión para futuros artículos o investigaciones:

- ¿Cómo se traduce este nivel de madurez a organizaciones que no tienen el mismo músculo financiero, pero sí una presión creciente por integrar IA y modernizar su stack?

- ¿Qué estrategias de formación, comunidad y estandarización pueden ayudar a cerrar la brecha de skills detectada globalmente y amplificada en la región?

(Data on Kubernetes 2025 Report, State of Cloud Native Development Q3 2025)

- ¿Cómo diseñar plataformas y prácticas que incorporen desde el inicio observabilidad, seguridad y FinOps, en lugar de añadirlos como “parches” cuando el TCO se vuelve inmanejable?

Seguimos la conversación

Este artículo parte de una necesidad compartida: tomar decisiones técnicas con mejor información en un contexto donde cloud native, datos e IA avanzan rápido y el margen de error es limitado.

En Cuemby trabajamos desde hace años con organizaciones y comunidades que se enfrentan a preguntas muy similares a las que atraviesan este texto: cómo llevar prácticas cloud native a producción, cómo diseñar plataformas que acompañen el negocio, cómo incorporar IA cuidando seguridad, observabilidad y costos. Esa experiencia nos mostró que los grandes reportes de la industria cobran verdadero valor cuando se traducen a contextos concretos y se vuelven materia de discusión dentro de cada equipo.

Si en tu organización, comunidad técnica o iniciativa educativa están explorando estos temas y quieren profundizar en alguno de los ejes del artículo —cloud native, Kubernetes en producción, datos, IA, observabilidad, FinOps o plataformas internas— nuestro equipo está disponible para conversar y aportar perspectiva.

- Puedes agendar una reunión con nosotros aquí:

https://app.lemcal.com/@cuemby/

- También puedes escribirnos directamente a:

elsa@cuemby.com

La invitación es sencilla: usar estos datos como punto de partida y, si lo consideras útil, abrir espacios de diálogo donde podamos contrastar realidades de mercados emergentes y construir juntos rutas más sostenibles para la adopción de tecnologías cloud native y de IA.

.svg)

.png)

.svg)